TV BRICS

India tiene la intención de comenzar a enviar turistas al espacio para 2030.

La Organización de Investigación Espacial India (ISRO) tiene la intención de lanzar vuelos turísticos espaciales para 2030. Según el jefe de la agencia espacial india, Sridhara Paniker Somnath , ISRO ya está trabajando en un módulo turístico, según informó TAAS .

«Actualmente, se está trabajando en el propio módulo de turismo espacial de la India, que será seguro y reutilizable«, dijo Somnath.

«Es probable que el precio del boleto sea de alrededor de 60 millones de rupias (alrededor de $700.000 dólares). Las personas que realicen este viaje también podrán llamarse astronautas«, agregó Somnath . En su opinión, estos son precios competitivos.

El jefe de ISRO, sin embargo, no especificó la altitud a la que se planea elevar a los turistas y cuánto tiempo pasarán en el espacio exterior.

Según funcionarios de ISRO, el programa fortalecerá la posición de India en el mercado global de servicios espaciales.

/ Imagen principal: © TV BRICS / istockphoto.com

InternacionalTV BRICSPolítica & Economía

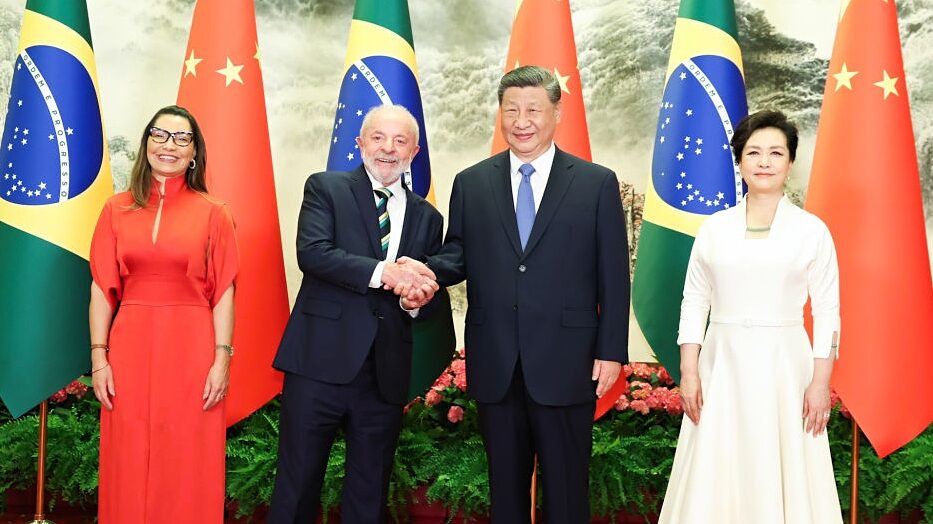

Presidentes de China y Brasil firmaron 20 acuerdos de cooperación

El presidente de China, Xi Jinping, mantuvo conversaciones con el presidente de Brasil, Luiz Inácio Lula da Silva, que llegó a China en visita de Estado. Así lo informó Xinhua News Agency, socio de la red TV BRICS.

Los líderes también asistieron a la cuarta reunión ministerial del foro China-Comunidad de Estados Latinoamericanos y Caribeños (CELAC) el 13 de mayo.

En las conversaciones bilaterales, Xi Jinping dijo que Pekín y Brasilia deberían aumentar los contactos bilaterales a varios niveles y combinar más activamente la iniciativa china «la Franja y la Ruta» con la estrategia de desarrollo de Brasil. Entre las áreas de cooperación más importantes, el presidente chino mencionó la agricultura, la energía, el espacio, la economía digital, la inteligencia artificial y las infraestructuras.

Además, Xi Jinping subrayó que China y Brasil, como dos grandes países en desarrollo de Oriente y Occidente, deben reforzar la coordinación en la ONU, los BRICS y otras plataformas internacionales.

Por su parte, Lula da Silva afirmó que las relaciones Brasil-China se basan en el respeto mutuo. Reiteró la voluntad del país de comprometerse con China en los asuntos internacionales para trabajar juntos en la defensa de los intereses del Sur Global.

«Estoy seguro de que el ejemplo que Brasil y China están dando hoy inspirará a las generaciones futuras, porque estamos demostrando que construir un mundo más justo nos permitirá crear algo diferente de lo que ocurrió en el siglo XX»

Luiz Inácio Lula da Silva

Presidente de Brasil

Tras la reunión, los líderes firmaron 20 acuerdos de cooperación en los ámbitos de la ciencia y la tecnología, la economía digital, las finanzas, la agricultura y otras áreas. También adoptaron dos declaraciones conjuntas, una de ellas sobre la creación de una Comunidad de Destino Común de la Humanidad para un mundo más justo y sostenible.

Fotografía: Xinhua News Agency

@TVBRICS

Sociedad TV BRICS

Díaz-Canel rinde homenaje a las víctimas de Leningrado en el monumento a la Madre Patria durante su visita a San Petersburgo

Este lunes, el presidente de Cuba, Miguel Díaz-Canel Bermúdez, rindió homenaje a las víctimas del sitio de Leningrado y a los soldados del Ejército Rojo caídos durante la Segunda Guerra Mundial.

La ceremonia tuvo lugar en el cementerio Piskaryovskoye de San Petersburgo, donde el mandatario cubano, acompañado por el ministro de Relaciones Exteriores, depositó una ofrenda floral ante el monumento a la Madre Patria.

En este lugar reposan los restos de más de 420.000 civiles fallecidos a causa del hambre, las enfermedades, los bombardeos y el invierno, así como de 70.000 soldados que defendieron la ciudad del cerco nazi. Así lo informó teleSUR, socio de TV BRICS.

Díaz-Canel recordó también a los jóvenes cubanos que combatieron en la Gran Guerra Patria, como los hermanos Vivó y Enrique Vilar. En el libro de visitas del memorial, expresó que Cuba no olvida el papel crucial de la Unión Soviética y el Ejército Rojo en la derrota del fascismo.

El líder cubano afirmó, que la resistencia de Leningrado es admirada por los pueblos del mundo. Como demuestra la historia, unidos por la solidaridad y la amistad se pueden enfrentar los retos del presente y del futuro.

La delegación cubana fue recibida por el presidente del Comité de Relaciones Exteriores de San Petersburgo, Yevgueni Grigóriev. Como parte de su agenda, Díaz-Canel sostendrá una reunión con el gobernador de la ciudad para explorar nuevas oportunidades de cooperación en economía, cultura y educación.

La visita coincide con el 65 aniversario del restablecimiento de relaciones diplomáticas entre Cuba y Rusia, y refleja la continuidad de los vínculos bilaterales en diversas áreas.

Fotografía: teleSUR / Presidencia de Cuba

@TVBRICS

InternacionalTV BRICSPolítica & Economía

Aviación civil de Brasil alcanza un récord histórico con más de 10 millones de pasajeros en marzo

En marzo, el sector de la aviación civil de Brasil alcanzó un hito histórico al superar por primera vez los 10 millones de pasajeros aéreos en un solo mes. Este crecimiento refleja un aumento generalizado en toda la industria, con máximos históricos también en vuelos internacionales y en volúmenes de carga aérea.

Más de 10,2 millones de pasajeros viajaron en rutas nacionales e internacionales, lo que representa un incremento interanual del 8 %. El tráfico nacional aumentó un 6 %, alcanzando los 7,9 millones de viajeros, mientras que los viajes internacionales crecieron un 15,5 %, llegando a 2,3 millones de pasajeros, según informó el sitio web oficial del Gobierno de Brasil.

Esta tendencia al alza se extiende también al transporte de carga, registrándose en marzo el mayor volumen de carga aérea para ese mes en los últimos 25 años: 116.000 toneladas, de las cuales más de 77.000 toneladas corresponden a envíos internacionales. El número de pasajeros internacionales lleva varios meses marcando récords, y la actividad aérea continúa en ascenso, con más de 13.300 salidas internacionales en marzo, la cifra más alta para un mes de marzo desde que comenzaron los registros en el año 2000.

Las rutas dentro de América del Sur, especialmente entre Brasil y Argentina o Chile, representaron la mayor parte de este tráfico.

Fotografía: iStock

@TVBRICS

-

![]() Sociedad 2 meses ago

Sociedad 2 meses agoUn nene de 8 años fue a jugar con amiguitos pero no volvió: apareció a las 4 de la madrugada a 3 kilómetros de su casa

-

![]() Espectáculos 2 meses ago

Espectáculos 2 meses agoCecilia Insinga reconoció la infidelidad de Diego Brancatelli con Luciana Elbusto: «El despecho que produce que no te elijan»

-

![]() Nacional / Política & Economía 2 meses ago

Nacional / Política & Economía 2 meses agoDesde este lunes los sanjuaninos pueden solicitar la nueva Licencia de Conducir Digital: cómo es el trámite online

-

![]() Sociedad / Sucesos 2 meses ago

Sociedad / Sucesos 2 meses agoEncontraron el cuerpo sin vida del jachallero que estaba desaparecido

-

![]() Sociedad / Sucesos 2 meses ago

Sociedad / Sucesos 2 meses agoMurió un joven de 16 años: chocó de frente contra un poste

-

![]() Espectáculos 2 meses ago

Espectáculos 2 meses agoMaría Valenzuela fue internada de urgencia en un centro de salud mental: qué le pasó

-

![]() Internacional / TV BRICS / Política & Economía 2 meses ago

Internacional / TV BRICS / Política & Economía 2 meses agoPresidentes de China y Brasil firmaron 20 acuerdos de cooperación

-

![]() San Juan / Política & Economía 2 meses ago

San Juan / Política & Economía 2 meses agoLegislatura de San Juan: se prepara para la entrega de la “Mención de Honor Maestro Mario Pérez” 2024